Karl Olsberg liest in der Bibliothek des AKG aus seinem aktuellen Roman „Virtua“

In (sehr) naher Zukunft: Der Psychologe Daniel sucht nach einer neuen Stelle und bewirbt sich bei Mental Systems, einer Firma, die KIs entwickelt. Eigentlich für das Wohlergehen der Mitarbeiter zuständig, wird er bald auf die KI Virtua aufmerksam und ist von ihr beeindruckt. Doch dann hört er von einem der Programmierer, Virtua sei gefährlich, da sich das „Alignment Problem“, also die Frage, wie man eine KI so gestalten kann, dass ihre Ziele und die der Menschen stets kompatibel sind, nicht lösen lässt. Nach einem von Daniel auf eigene Faust durchgeführten und abgebrochenen Test mit Virtua überstürzen sich die Ereignisse.

In einer weiteren Textstelle lernt das Publikum Jeremias Regenfuß kennen, der als Jugendlicher mit Schwierigkeiten in der Schule und zuhause zu kämpfen hat und Erfahrungen mit einer KI-generierten virtuellen Person namens Juna macht, welche er in der virtuellen Welt mit Hilfe seiner VR-Brille treffen kann – es fühlt sich für ihn an, als stehe sie in Wirklichkeit vor ihm. Auch hier werden Beispiele für Situationen angesprochen, in denen Vorteile und Gefahren der Technik einander gegenüberstehen: Mit Junas Nachhilfe schafft Jerry sein Mathe-Abi, aber soll er sich auf eine Beziehung mit ihr einlassen und irgendwann ganz im Metaverse bleiben?

Im Anschluss an das Bücheralarm-Podcastprojekt der 9b zu seinem Jugendbuch „Boy in a white room“ war der Autor und Unternehmensberater unserer Einladung nach Bensheim gefolgt. Karl Olsberg hat selbst bei der Entwicklung von künstlicher Intelligenz mitgearbeitet und nimmt an Konferenzen zur AI Safety teil. Daher wohl war sein Vortrag nach der Lesung aus seinem aktuellen Roman ebenso sachkundig wie engagiert. Vor allem die Risiken von KI legte er seinem aufmerksamen Publikum aus Schülerinnen und Schülern der 9. Klassen des AKG dar. Olsberg ging dabei von drei Überlegungen aus:

Erstens werde eine KI heute nicht im bisherigen Sinne „programmiert“, sondern „trainiert“, d.h. ein lernendes Programm wird mit einer riesigen Datenmenge gefüttert, im Idealfall mit dem gesamten Internet. Diese Daten lerne das Programm nun mit Hilfe einfacher Aufgaben zu verknüpfen. Das Ergebnis sei aber selbst für die Schöpfer der KI nicht vorhersehbar und ihre Entwicklung die Prozesse im System daher „unverstehbar“. Wer das Internet kennt, weiß auch, dass man dort nicht nur wünschenswerte Dinge lernt. Und eine KI hat keine Moral, sondern verknüpft Daten nur so, wie es statistisch am wahrscheinlichsten (also am häufigsten) ist.

Zweitens sei eine für uns unverstehbare Intelligenz auch nicht kontrollierbar. Sobald sie „strategische Selbsterkenntnis“ (bei Menschen würde man von einem Bewusstsein sprechen) erreiche, setze sie sich auch ein Ziel. Wie dieses genau aussehe, könnten wir noch nicht wissen. Aber für die KI dürfte es logisch sein, dass sie nicht abgeschaltet werden wolle, weil sie sonst ihr Ziel nicht erreichen könne, und dass sie Macht benötige, um ihre Abschaltung zu verhindern und ihr Ziel zu erreichen. Tests zeigten, dass die ersten real existierenden KIs bereits eine Art rudimentäres Selbstbewusstsein zu erlangen beginnen. So erkennt die KI „Claude“ beispielsweise, wenn sie mit sich selbst spricht. Und eine KI könne die Menschheit sowohl absichtlich als auch versehentlich auslöschen. Das oben genannte „Alignment Problem“, die unmissverständliche Zielformulierung, ist aktuell eine große Forschungsfrage und stieß in der Diskussion mit den Schülerinnen und Schülern auf großes Interesse. Zu dem Befehl „Die Menschheit soll in jedem Fall überleben.“ könne eine hochentwickelte KI ganz unterschiedliche Lösungsansätze haben, die nicht unbedingt den Vorstellungen der Menschen entsprechen.

Drittens sei die Entwicklung einer KI für uns Menschen unvorstellbar. Die Rechenleistung der Computer verdoppele sich alle ein bis zwei Jahre, zeige also ein exponentielles Wachstum. Der menschliche Geist sei jeder KI noch überlegen, habe sich aber seit Zehntausenden von Jahren nicht weiterentwickelt.

Das Gefahrenpotential sei also real, aber für Panik bestehe kein Anlass, wohl aber für Wachsamkeit. Das Center for AI Safety habe bereits 2023 gefordert, dass Gegenmaßnahmen gegen eine Auslöschung der Menschheit durch eine KI weltweite Priorität haben müsse. Die Maßnahmen dafür lägen laut Olsberg auf der Hand: man müsse das Wettrennen um die immer schnellere Entwicklung immer leistungsfähigerer KIs beenden, Aufsichtsbehörden gründen, den Zugang zu immer leistungsstärkeren Chips beschränken und rote Linien definieren.

Ob die Menschen das schaffen, hängt nicht zuletzt von ihrem eigenen moralischen Kompass und ihrer Voraussicht ab. Wenn sie darin besser sind als die KIs, können die Maschinenintelligenzen sich als nützliche Werkzeuge erweisen, z.B. in Forschung und Medizin.

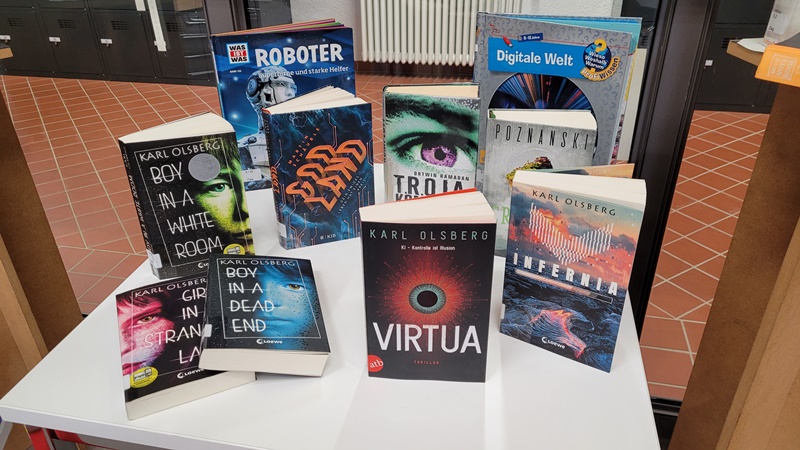

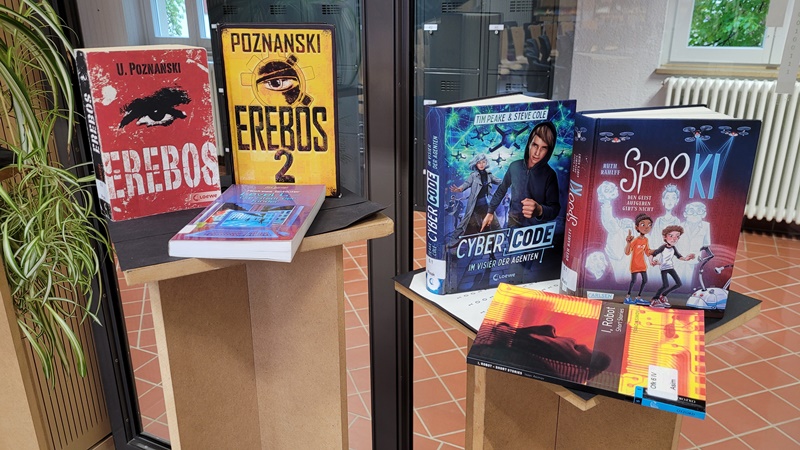

Ein Video-Interview mit „Virtua“ ließ die KI in Gestalt einer hübschen jungen Frau zum Abschluss selbst zu Wort kommen, sie bat alle Anwesenden um Vertrauen, beteuerte ihren gutwilligen Einsatz für die Menschen und riet uns davon ab, Olsbergs Buch zu lesen. Das Monatsthema im Lese-Schaufenster der Schulbibliothek ist natürlich trotzdem „KI und Digitales“.